La Revolución del Mixture of Experts en la IA: El Caso de Mistral

hace 1 año

En el competitivo mundo de la Inteligencia Artificial (IA), la startup francesa Mistral ha irrumpido con una propuesta revolucionaria que promete cambiar las reglas del juego. Conocida por su compromiso con el modelo Open Source, Mistral ha logrado destacar por ofrecer contenido gratuito y accesible a todos, posicionándose como la empresa de IA más grande de Europa. Sin embargo, su última innovación, presentada el viernes pasado, ha elevado su perfil aún más en el sector.

Mixal: Un Modelo Open Source Superador

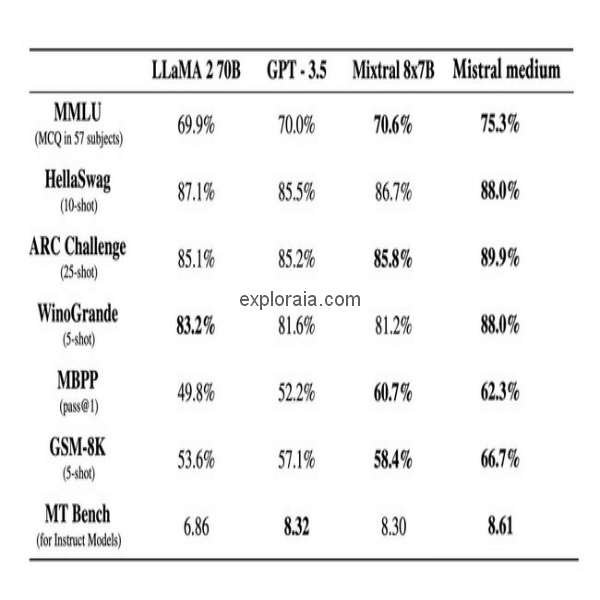

El nuevo modelo de Mistral, denominado Mixal (también referido como 7B-8X o 8X-7B), no solo ha superado a gigantes de la IA como el Meta Llama 270B o el modelo chino Quen 72B, sino que lo ha hecho de manera notable. Con solo 56,000 millones de parámetros, Mixal es más pequeño que sus competidores pero seis veces más rápido, gracias a una novedosa estructura denominada 'mixture of experts' (MoE).

Mixture of Experts: La Clave de la Eficiencia

La estructura MoE es un concepto que, aunque no es nuevo, ha sido magistralmente implementado por Mistral en los LLM (Language Learning Models) actuales. Esta metodología consiste en dividir el conocimiento en diferentes sectores especializados. En el caso de Mistral, se crean ocho modelos más pequeños, cada uno con 7,000 millones de parámetros. Un modelo distribuidor se encarga de asignar las consultas al experto más adecuado, lo que resulta en un procesamiento más eficiente y rápido.

Impacto en el Mercado y Futuro de la IA

El modelo Mixal no solo es un logro técnico significativo para Mistral, sino que también representa un cambio de paradigma en el mercado de la IA Open Source. Este avance podría inspirar a otros proyectos como Yama de Meta, que podrían aplicar la técnica MoE a sus propios modelos, cerrando la brecha con modelos privados como el Chat GPT-4.

La importancia de Mistral en el panorama de la IA se ve reforzada por su papel en la legislación europea sobre IA, abogando por una regulación más flexible para los modelos Open Source. Esto ha permitido a Mistral lanzar su modelo avanzado justo después de la aprobación de la nueva legislación, posicionando a Europa en un lugar más prominente en el mundo de la IA.

Conclusión: Un Futuro Más Eficiente y Accesible

El desarrollo de Mixal y la aplicación de la estructura MoE en los LLM abre un nuevo capítulo en la historia de la IA. Este enfoque no solo ofrece una mayor eficiencia y velocidad, sino que también democratiza el acceso a la tecnología de punta en IA. Con la proliferación de este modelo, estamos ante el umbral de una era donde la IA es más accesible, rápida y especializada, marcando un antes y un después en el sector.

Si quieres conocer otros artículos parecidos a La Revolución del Mixture of Experts en la IA: El Caso de Mistral puedes visitar la categoría Tecnología y IA.

Deja una respuesta